Twin Speaks je umetna dvojica v dialogu. Dialog je sestavljen iz gibov in glasov. Oboje izhaja iz telesa in je pri živih bitjih zlito v eno – gib povzroči glas in glas povzroči gib. Podobno je dialog abstrakcija na ravni vzajemnega odnosa, kjer zlitje poteka med dvema v dialogu vpetima stranema. Gib dobi protigib in glas dobi protiglas. Seveda se lahko v idealnem primeru glasova tudi združita v eno pesem. Ali razdružita v nepovezano besedičenje.

Opis pojavnosti:

Twin Speaks je rezultat več smeri razvoja, ki sem jih zasledoval v zadnjem desetletju in pol. Prvi je razvoj interaktivno-generativne strukture, ki nagovarja metafore identitet in vlog v procesu komunikacije. Ta sega v leto 2004 s projektom Orakelj, ki se je ponovno pojavil v letu 2010 v obliki interaktivne instalacije Orakelj II (“Avtoportret”). Druga smer vzpostavljanja pogojev za ta projekt je razvoj brezžičnih vmesnikov, ki sem jih kot pretežno funkcionalne naprave zasnoval in razvil v letu 2016 v okviru projekta Cirkulacija 2: Kulturni vmesniki. Tretja/ hkratna študija je zasnova in izdelava avtonomne (generativne in interaktivne) zvočne instalacije z abstrahiranim senzorskim vmesnikom leta 2015, ki se je imenovala Wardenclyffe Tower. Vsebovala je dva povezana računalnika: senzorski (arduino) in zvočno-algoritmični računalnik (orange pi ali raspberry pi).

Razmisleki

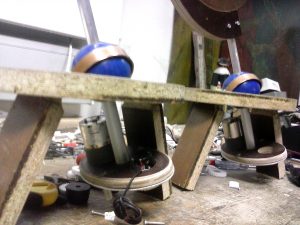

Najpomembnejši razmislek za projekt Twin Speaks je domislek o možnostih, ki jih nudi povezava dveh identičnih objektov, ki imata možnost izražanja na način gibanja/ pogleda in zvoka/ govora. Na mojo pobudo je Stefan Doepner v oktobru 2016 zgradil dve identični mehaniki z dvema zvočnikoma-trobljama, jaz pa elektroniko in prvo stopnjo programiranja sistema. Tedaj gostujoči švicarski umetnik Michael Egger je prilagodil program, ki omogoča objektoma računalniški vid in sledenje s pogledom (“personifikacija osebe s strani stroja”) in odpira prostor potencialne komunikacije med objektoma in obiskovalci.

Najpomembnejši razmislek za projekt Twin Speaks je domislek o možnostih, ki jih nudi povezava dveh identičnih objektov, ki imata možnost izražanja na način gibanja/ pogleda in zvoka/ govora. Na mojo pobudo je Stefan Doepner v oktobru 2016 zgradil dve identični mehaniki z dvema zvočnikoma-trobljama, jaz pa elektroniko in prvo stopnjo programiranja sistema. Tedaj gostujoči švicarski umetnik Michael Egger je prilagodil program, ki omogoča objektoma računalniški vid in sledenje s pogledom (“personifikacija osebe s strani stroja”) in odpira prostor potencialne komunikacije med objektoma in obiskovalci.

Vmesne možnosti pa so vse tiste, ki potekajo med entitetama – kjer se gibanje in govor ene entitete neposredno nanaša na drugo – izmenjujeta komplementarne gibe/ besede – sta sprijeti v dialog. Pri tem takoj na začetku ne računam na uporabo naprednih principov umetne inteligence, ampak na večje število scenarijev, ki pa lahko preskočijo na nepredvidljiv način – in ob tem ohranijo koherenco/ smisel. Se pravi: algoritmika.

V nadaljevanju razmisleka so se želje precej spremenile. Troblje, ki so na nek način zaščitni znak Cirkulacije 2, so se umaknile drugačni identiteti – robota/ aliena. Enostavna zasnova s posnetimi glasovi in naključno izbiro se je umaknila bolj kompleksni obliki generiranega govora. Tudi možnosti gibov, ki bi lahko prevzeli nase imitacijo človeškega telesnega psevdo-jezika (“body language”), so zahtevale popolno prenovo mehanike.

Koncept

Avtonomija umetnih stvorov je zaenkrat še zelo magična, kadar jo obiskovalec zazna. Vedno povzroči, da človek entiteto identificira kot osebo – personalizira. Entiteta-objekt postane identiteta-oseba (najmanj hišni ljubljenček). Naslednja stopnja bi bila verjetno že poimenovanje. Umetna inteligenca (AI) v določeni meri še okrepi koncept avtonomije z (bolj) smiselnimi interaktivno-generativnimi lastnostmi. V neki točki razvoja bo umetna inteligenca postala del vsakdana. Fascinacije, magije ne bo več. Ime projekta Twin Speaks cilja na kultno nadaljevanko Twin Peaks režiserja Davida Lyncha, kjer je prav magičnosti podeljena izjemna vloga.

Entiteti/ trobili sta opremljena z računalniškim vidom, ki zazna človeško prisotnost – identificira človeški obraz – in lahko zato pogledata v pravo smer – v oči človeka. Med seboj sta povezana prek brezžične povezave, zato obe entiteti vedno dokaj dobro vesta, kaj dela druga. Dvojica lahko tako gleda sinhrono: dvoje oči spremlja gibanje obiskovalca, ali pa asinhrono: vsaka spremlja svojega obiskovalca in ga nagovarja. Imamo torej osnovni kvaliteti komunikacije: soočenje in nagovor.

Ko se entiteta usmeri na obiskovalca, je to pogled. Lahko gledata eden drugega in se tako definirata kot ločeni entiteti. Če sta sinhrona, potem se zlijeta v eno osebo – dvoje oči. Kadar ena spremlja obiskovalca, druga pa gleda prvo, je to pogled tretjega (“drugega”). Možnosti so torej zelo raznolike in so lahko zato prava študija identitet in vlog, ki jih dinamično pridobivajo in spreminjajo entitete – obiskovalci so pri tem bistveno vključeni. Seveda gre pri tem spet za metaforo medčloveških odnosov, ki me kot umetnika zanimajo že ves čas.

Dve bistveni dinamiki instalacije dvojice sta torej: gibanje in zvok. Bistveno je prej opisano gibanje, zvok pa kot le malo manj bistven element, ki vključuje tudi (povedne) tišine. Z zvokom se vključuje moment nanašanja in povedne komunikacije. Zvok posamezne entitete je nujno podrejen njegovemu gibu – meta govorica telesa je pred povedjo. Ni pa nujno, da je zvok človeški govor – varianta programa lahko zlahka izvede koncert za dve troblji glavi.

Izdelava:

Faze izdelave novega koncepta robotskih entitet:

- This is just a concept image – not a working robot

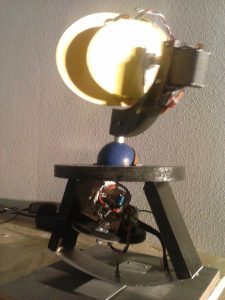

- This is first (alpha) single version of moving head (Oracle Pitia)

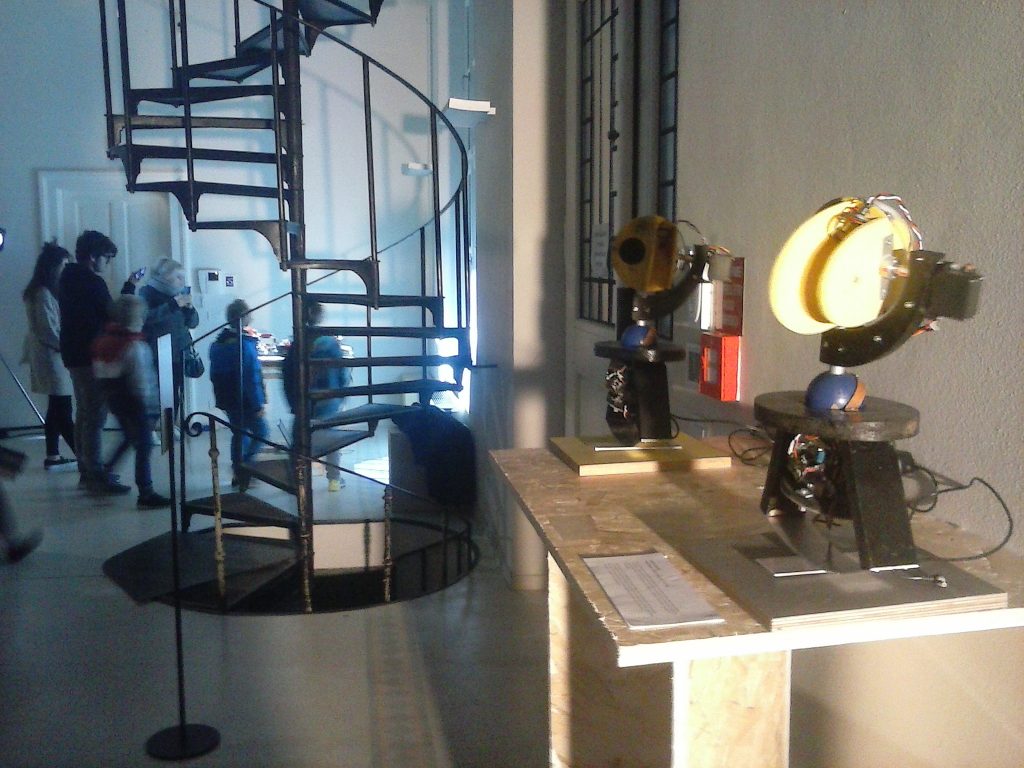

- At Arte e Robotica festival in Trieste (november 2018

Zadnji dodatek (v začetku 2019) je bilo oblikovanje in izdelava posebnih – razmeroma univerzalnih tiskanih vezij, ki bi mi omogočala enostavnejši razvoj in izdelavo prototipov nekaterih sistemov, ki jih razvijam:

Zadnji dodatek (v začetku 2019) je bilo oblikovanje in izdelava posebnih – razmeroma univerzalnih tiskanih vezij, ki bi mi omogočala enostavnejši razvoj in izdelavo prototipov nekaterih sistemov, ki jih razvijam:

* twinSpeaks variante z do 4 servo-motorji, z brezžično, ir in midi-povezavo

* iballs variante pozicijskega senzorja, z brezžično, ir in midi-povezavo – oddajnika

* ter iballs sprejemnik večih iballs oddajnikov – z LCDjem in usb povezavo na računalnik

Tehnični opis:

Tehnična izvedba se v tem projektu tiče skoraj samo še programskega razvoja, saj je osnovni mehanski in elektronski sistem že narejen. Vendar ta razvoj ni trivialen – vključuje uporabo naprednih oblik algoritmike in drugih vzvodov t.i. umetne inteligence.

Zasnova sistema temelji na mikro-kontrolerju Arduino, ki skrbi za t.i. meta-jezik / povedne gibe in mini-računalniku Raspberry PI, ki prevzame nase multimedijska zvok in vid. Osnovna komunikacija med entitetami poteka na bazičnem mikrokontrolerju, zahteve po pomenu pa so abstrahirane v računalniku Raspberry PI.

Raspberry PI naj bi torej skrbel za višje abstrakcije – kot je razpoznavanje vzorcev v slikah in umetni govor oziroma celo razumevanje govora. Razvoj na tem področju je v zadnjem času bliskovit – na voljo so že odprtokodne rešitve – IoT (“interet of things”), skratka. Hkrati pa je že jasno, da je npr. raspeberry pi kljub 4 jedrom prešibak.

Nekaj pomembnih linkov za vzpostavitev sistema.

Some quick notes to have the system running.

Arduino Pro Mini to drive max 4 servo motors, communicate between entities via packet radio exchanging midi formatted messages. Keep the low-level communication patterns/ behaviour/ movements as meta-language – to be reused with any kind of text/ topic/ scenario. Remember some data on exit.

Raspberry PI 3

- create startup

- connect internal midi devices (aconnect … )

- use puredata to send and receive midi data via serial out

- use ttymidi serial app to connect midi formatted data between midi ins and outs

text to speech:

- use festival with some voices

http://www.cstr.ed.ac.uk/projects/festival/

with linux

https://www.maketecheasier.com/make-computer-talk-with-festival/ - trigger festival (or espeak,…) via python script

visual recognition:

- generate twinspeaks bot object

https://coding-robin.de/2013/07/22/train-your-own-opencv-haar-classifier.html - get positive training images via video

https://docs.opencv.org/3.0-beta/doc/py_tutorials/py_gui/py_video_display/py_video_display.html - use pi camera

- python script and OpenCV will recognize faces, bots, etc. and send data (1-8-15: left right; 1-8-15: up down) to puredata to either follow the movement or decide for dialog

my RSS

my RSS